من ReAct إلى Agent-R1: فصل جديد في مسيرة وكلاء الذكاء الاصطناعي 👋🔥

المشكلة في أنظمة الوكلاء الحالية (مثل ReAct) هي تعاملها مع البيئة ككيان ساكن ومسارات عمل مصممة بشرياً، بينما يتطلب الواقع اتخاذ قرارات متسلسلة وتكيّفاً مع ردود فعل احتمالية، وهو ما يجعل التعلم المعزز (RL) هو المسار الطبيعي لتدريب وكلاء المستقبل !!

لماذا يعتبر Agent-R1 نقلة جريئة في بناء الوكلاء الأذكياء ::

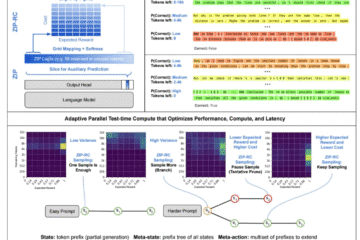

✴️ تدريب (End-to-End): يتيح الإطار تدريب الوكلاء على التفاعلات المتعددة، متجاوزاً أساليب سير العمل اليدوية التي تحد من قدرة الوكيل على الإبداع في حل المشكلات.

✴️ توسيع إطار قرار ماركوف (MDP): تم تطويره ليشمل سجل التفاعل الكامل وتغذية البيئة المرتدة، لضمان استيعاب الوكيل للنتائج غير المتوقعة عند استخدام الأدوات الخارجية.

✴️ دقة الـ (Credit Assignment): عبر تقنية Action Mask يتم التمييز بين الرموز التي ولدها الوكيل وبين ردود فعل البيئة، لضمان أن التعلم يستهدف قرارات الوكيل الفعلية فقط، وبالتالي تحسين كفاءة التعلم.

✴️ تفوقت العوامل المدربة بالتعلم المعزز بشكل كاسح؛ حيث حققت خوارزمية GRPO معدل دقة (EM) بلغ 0.3877 مقارنة بـ 0.1328 فقط لأنظمة RAG التقليدية.

👋 إن جوهر الذكاء الاصطناعي الفعال لا يكمن في سعة ذاكرته فحسب، بل في قدرته على المناورة داخل بيئات عمل متغيرة ومعقدة !!

[ يثبت Agent-R1 أن تخصيص عملية التعلم للوكيل ليفهم “تبعات أفعاله” هو المفتاح الحقيقي للوصول إلى استقلالية برمجية كاملة ] 💡

رابط الورقة 🔗 👇

سوريا

سوريا

مصر

مصر

الإمارات

الإمارات

السعودية

السعودية

قطر

قطر